1.咱们首要能够去阿里云或许华为云去租借一台服务器,毕竟一个初级版本的服务器,也没有那么贵,阿粉仍是用的之前租借的那台,咱们选择装置 Linux8 的版本,假如是本机的话,你需求下载 CentOS8 的镜像,然后经过虚拟机装置到 VM 上就能够了,装置完结咱们就能够开端装置 Hadoop 了

咱们先说说 Hadoop 都能干啥,以及人们常常对 Hadoop 误解。

Hadoop首要是分布式核算和存储的框架,所以Hadoop工作过程首要依赖于HDFS(Hadoop Distributed File System)分布式存储系统和Mapreduce分布式核算框架。

可是很多人就会对 Hadoop 发生一个误解,有些非常捧 Hadoop 的人就会说,Hadoop 什么东西都能够做,实际上不是的,每一项技能的呈现,都是对应着解决不同的问题的,比方咱们接下来要学习的 Hadoop 。Hadoop适合来做数据分析,可是肯定不是 BI ,传统 BI 是归于数据展示层(Data Presentation),Hadoop便是专心在半结构化、非结构化数据的数据载体,跟BI是不同层次的概念。

还有人说 Hadoop 便是 ETL ,就相当于数据处理,可是,Hadoop 并不是一个肯定意义上的 ETL 。

1.装置SSH

yum install openssh-server

OpenSSH是Secure Shell的一个开源实现,OpenSSH Server装置完结后在/etc/init.d目录下应该会添加一个名为sshd的服务,一会咱们就要把生成的密钥放到指定位置,然后用来当作之后的身份验证。

2.装置 rsync

yum -y install rsync

3.发生 SSH 密钥之后持续进行后续的身份验证

ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa

4.把发生的密钥放入答应文件中

cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

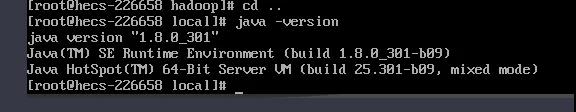

装置 Hadoop 之前咱们要先把 JDK 装置好,装备好环境变量,呈现下面这个姿态,就说明 JDK 已经装置完结了。

1.解压Hadoop

咱们先要把 Hadoop 放到咱们的服务器上,就像阿粉这个姿态,

然后解压tar zxvf hadoop-3.3.1.tar.gz

2.修正bashrc文件

vim ~/.bashrc

export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64/ export HADOOP_HOME=/usr/local/hadoop export PATH=$PATH:$HADOOP_HOME/bin export PATH=$PATH:$HADOOP_HOME/sbin export HADOOP_MAPRED_HOME=$HADOOP_HOME export HADOOP_COMMON_HOME=$HADOOP_HOME export HADOOP_HDFS_HOME=$HADOOP_HOME export YARN_HOME=$HADOOP_HOME export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native export HADOOP_OPTS="-DJava.library.path=$HADOOP_HOME/lib" export JAVA_LIBRARY_PATH=$HADOOP_HOME/lib/native:$JAVA_LIBRARY_PATH

复制到文件中保存退出

3.生效文件

source ~/.bashrc

4.修正装备文件 etc/hadoop/core-site.xml

fs.defaultFS hdfs://localhost:9000 hadoop.tmp.dir /app/hadooptemp

5.修正 etc/hadoop/hdfs-site.xml

dfs.replication 1 dfs.http.address 0.0.0.0:9870

6.修正 etc/hadoop/hadoop-env.sh

export JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk-1.8.0.212.b04-0.el7_6.x86_64

7.修正etc/hadoop/yarn-env.sh文件

export JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk-1.8.0.212.b04-0.el7_6.x86_64

8.修正sbin/stop-dfs.sh文件,在顶部添加

HDFS_NAMENODE_USER=root HDFS_DATANODE_USER=root HDFS_SECONDARYNAMENODE_USER=root YARN_RESOURCEMANAGER_USER=root YARN_NODEMANAGER_USER=root

HDFS_NAMENODE_USER=root HDFS_DATANODE_USER=root HDFS_SECONDARYNAMENODE_USER=root YARN_RESOURCEMANAGER_USER=root YARN_NODEMANAGER_USER=root

9-1.修正start-yarn.sh 文件

YARN_RESOURCEMANAGER_USER=root HADOOP_SECURE_DN_USER=yarn YARN_NODEMANAGER_USER=root

9-2.修正stop-yarn.sh文件

YARN_RESOURCEMANAGER_USER=root HADOOP_SECURE_DN_USER=yarn YARN_NODEMANAGER_USER=root

上面的这些指令首要是用于当你发动 Hadoop 的时分,会提示认证不经过。

10.格式化,进入hadoop的bin文件夹,执行下面的指令

./hdfs namenode -format

11.进入sbin文件夹,发动hadoop

./start-dfs.sh

也能够直接全部发动./start-all.sh

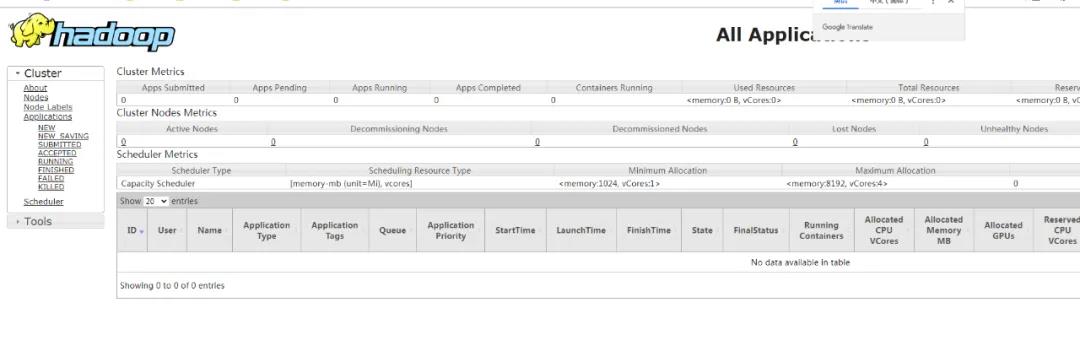

然后直接拜访8088端口即可

12.防火墙开启端口,假如用的云服务器,请将9870端口加入安全组出入口

//添加9870端口到防火墙 firewall-cmd --zone=public --add-port=9870/tcp --permanent //重启防火墙 firewall-cmd --reload

13.输入 jps 假如是假如是4个或许5个就装备成功,再持续

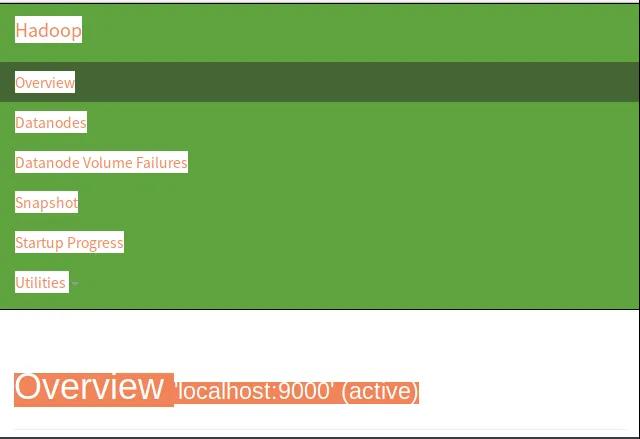

经过web拜访hadoop,拜访地址:http://IP地址:9870

当咱们看到这个的时分,说明咱们已经装置成功了。留意,Hadoop3.x 版本的看 Hadoop Web端的端口没有变化,可是 HDFS 端 则由 50070 变成了 9870 这个需求留意一下呦,你学会了么?